通义千问开源320亿参数模型,已实现7款大语言模型全开源

科技IT

2024

04-07

19:25:56

分享

4月7日消息,阿里云通义千问开源320亿参数模型Qwen1.5-32B,可最大限度兼顾性能、效率和内存占用的平衡,为企业和开发者提供更高性价比的模型选择。目前,通义千问共开源了7款大语言模型,在海内外开源社区累计下载量突破300万。

通义千问此前已开源5亿、18亿、40亿、70亿、140亿和720亿参数的6款大语言模型并均已升级至1.5版本,其中,几款小尺寸模型可便捷地在端侧部署,720亿参数模型则拥有业界领先的性能,多次登上HuggingFace等模型榜单。此次开源的320亿参数模型,将在性能、效率和内存占用之间实现更理想的平衡,例如,相比14B模型,32B在智能体场景下能力更强;相比72B,32B的推理成本更低。通义千问团队希望32B开源模型能为下游应用提供更好的解决方案。

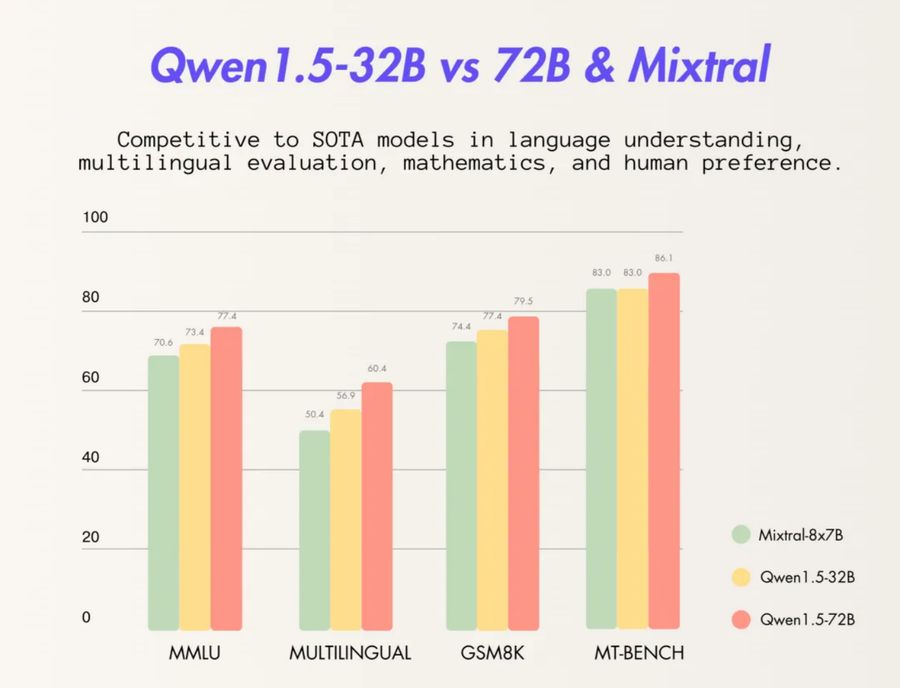

基础能力方面,通义千问320亿参数模型在MMLU、GSM8K、HumanEval、BBH等多个测评中表现优异,性能接近通义千问720亿参数模型,远超其他300亿级参数模型。

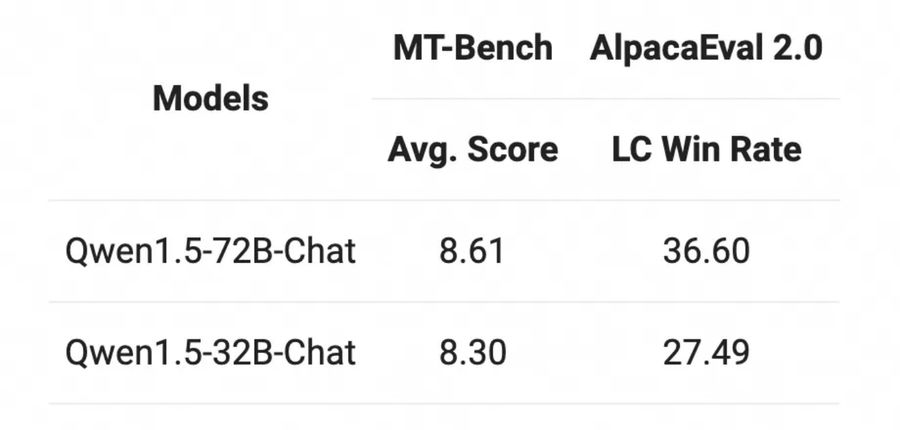

Chat模型方面,Qwen1.5-32B-Chat模型在MT-Bench评测得分超过8分,与Qwen1.5-72B-Chat之间的差距相对较小。

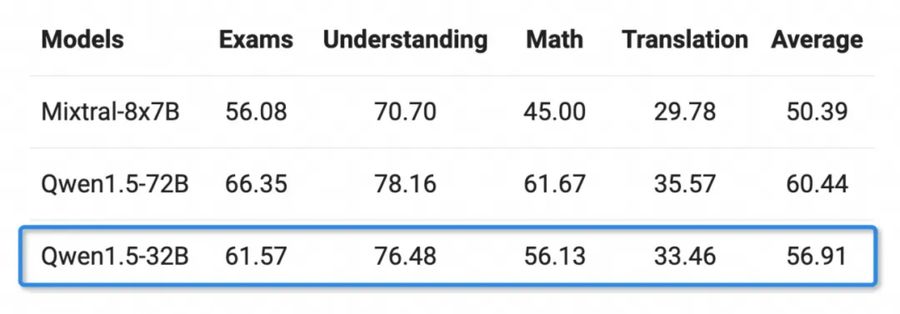

多语言能力方面,通义千问团队选取了包括阿拉伯语、西班牙语、法语、日语、韩语等在内的12种语言,在考试、理解、数学及翻译等多个领域做了测评。Qwen1.5-32B的多语言能力只略逊于通义千问720亿参数模型。

- About

- Latest Posts

- 通义千问开源320亿参数模型,已实现7款大语言模型全开源 – 2024年4月7日

- 杨元庆:联想中国区是公司大本营和全球业务基本盘 – 2024年4月2日

- 浪潮海若大模型业务战略正式发布 – 2024年4月2日

The End

免责声明:本文内容来源于第三方或整理自互联网,本站仅提供展示,不拥有所有权,不代表本站观点立场,也不构成任何其他建议,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容,不承担相关法律责任。如发现本站文章、图片等内容有涉及版权/违法违规或其他不适合的内容, 请及时联系我们进行处理。

最新文章

- 行业首个!星纪元ET搭载黄金增程技术通过中汽中心验证,技术“敢超越”! 2025-01-21

- 加速出海,趣链科技亮相香港Web3.0标准化协会年度盛会 2025-01-21

- 中科星图低空云发布:支持城市上空飞行空域管控、态势监视、计划管理等 2025-01-21

- 新年玩转老钱风!卡西欧 SHEEN 新品发布,以圆舞曲演绎宫廷复古奢华! 2025-01-21

- 全新星纪元ET增程四驱、问界M7、理想L7 深度测评,冬季购车不踩坑! 2025-01-20

- Apple 第八年发布新春大片:想和你一起听听歌 2025-01-20

- 蓝牙技术联盟宣布2025蓝牙亚洲大会重磅回归 2025-01-20

- 小红书两天涌入多少海外TikTok用户? 知情人士透露细节 2025-01-20

相关推荐

标签云

友情链接