蚂蚁集团:构筑完善的安全治理体系,推进模型能力快速提升

1月8日,北京智源人工智能研究院从Scaling Law、基础模型、具身智能、超级应用、AI安全等关键方向发布了覆盖从基础设施到产品应用场景的“2025十大AI技术趋势”,针对每个趋势观点,给出其可成为2025年度趋势的论证逻辑。其中在AI安全趋势方面,智源研究院认为,模型能力提升与风险预防并重,AI安全治理体系持续完善。

作为复杂系统,大模型的Scaling带来了涌现,但复杂系统特有的涌现结果不可预测、循环反馈等特有属性也对传统工程的安全防护机制带来了挑战。基础模型在自主决策上的持续进步,带来了潜在的失控风险。与此同时,在信息传播速度日益加快的当下,由AI系统引发的偏见、深度伪造、隐私泄露、版权争议问题丛生,社会对AI安全的关注度急剧上升。

蚂蚁集团科技战略与执行部副总经理彭晋

如何引入新的技术监管方法,如何在人工监管上平衡行业发展和风险管控?这对参与AI的各方来说,都是一个值得持续探讨的议题。蚂蚁集团科技战略与执行部副总经理彭晋进行了深度解读。

大模型安全问题的本质

彭晋认为,大模型安全问题的本质可以从以下几个层面来分析。

首先,从大语言模型、多模态模型和生成式AI角度,它其实是海量的数据加海量算力的知识压缩,在迁移、学习等压缩过程中面临信息的损失(因token通过概率预测方式生成)。基于生成式的架构,由于预测问题,幻觉难以避免。

在数据层面,一方面,输入的数据本身可能含有有害样本,另一方面,数据存在导向性问题、数据本身质量参差不齐,进一步恶化了生成式的输出质量。在训练过程中,还可能涉及到个人信息数据以及版权数据。无论从宏观角度还是输出角度,都会导致安全问题。

第三,从算法角度,模型是深黑盒状态,可控性存在一定的问题,生成结果也呈不可控性。可解释性问题在深度学习时就已经存在,在大模型之前就大量应用人工智能的算法来做强风控等工作,在小模型时,监管可能会提出类似为什么把某个人的信贷额度评定过高,为什么把某个业务界定为诈骗、列入黑名单等。这些内容具有一定可解释性。深度学习在可解释性方面存在一定的困难,而大模型阶段因为是深黑盒,可解释性进一步恶化。

第四,在应用层面,生成式AI在普通对话领域的流畅度非常好,但是在医疗、金融等应用场景,因为需要专业的语料来加持,而且很多知识并没有被数字化、被向量化,容易在专业领域出现被滥用的情况,进一步产生幻觉的内容。比如对男性症状进行推理时,会发现出现女性症状的表达。由于大模型从互联网抓取的知识并非准确,难于精确回答医疗诊断、金融的问题以及实时性等,在应用方面存在很大的安全问题。

第五,攻击方面出现了新的方式。以前经常谈及SQL注入等攻击,在大模型中则是绕过模型安全手段的prompt注入、诱导、越狱等攻击,引发大模型回答一些不该回答的问题。

总而言之,大模型的风险包括生成幻觉、隐私敏感数据泄露、价值观导向、专业度缺失、伦理等等问题。

专家热议:人工智能飞速进步背景下的极端风险管理

大模型本身是个信息系统,传统信息系统的漏洞等各种安全问题,也会发生在大模型身上。无论是从平台,还是从框架、插件等等角度,都可能存在系统漏洞,这些漏洞进一步导致模型丢失、数据泄露、可用性等从底层模型生成逻辑的安全问题。

2024年5月科学(《Science》)杂志发表了一篇叫Managing Extreme AI Risks Amid Rapid Progress(“人工智能飞速进步背景下的极端风险管理”)的文章,作者包括三位图灵奖得主oshua Bengio、Geoffrey Hinton、姚期智以及诺贝尔经济学奖得主Daniel Kahneman在内的25位专家学者。

文章指出,随着AI技术的快速发展,特别是通用型AI系统的发展,其自主性和能力的增强可能会大幅放大AI的影响,并带来一系列风险,如大规模社会危害、恶意使用以及人类可能失去对自主AI系统的控制等——因为它的不可解释性以及深黑特性,可能导致对未来不可知的安全风险。

尽管研究人员已经对AI的潜在极端风险发出警告,但在如何管理这些风险方面仍然缺乏共识。

当前的社会回应和治理措施与专家们预测的发展速度和变化程度相比显得不足,特别是在AI安全研究方面存在滞后。

目前的治理举措缺少有效的机制和机构来预防滥用和不谨慎行为,并且几乎未涉及对自主系统的管理。

基于其他关键安全技术的经验教训,文章提出了一个综合方案,旨在结合技术研发与主动、适应性的治理机制,以更好地准备应对AI带来的挑战。

基于AI模型治理展开的大量卓有成效的工作

过去一年,国内外在AI模型治理方面开展了大量的工作,其中主要是推进标准化工作:

2月,全国网络安全标准化技术委员会发布《生成式人工智能服务安全基本要求》,包括对模型训练语料、模型安全、模型标注、模型安全性如何评估等,现在已经形成技术文件,将会变成一个国家标准;

3月,智源人工智能研究院发起《北京AI安全国际共识》,参与专家包括Yoshua Bengio、Geoffrey Hinton、姚期智、Stuart Russel、张宏江、张亚勤、薛澜、黄铁军等,强调模型不能突破的自我演进、自我复制、自我权利增长等红线问题,并对模型的开发者、提供者进行约束,欧盟《人工智能法案》也于同月通过,按照对社会影响程度风把模型分成不可接受的风险、高风险、有限风险和最低风险等维度;

蚂蚁集团数据治理和发展部总监吴映京介绍人工智能应用中的个人信息保护工作

4月,WDTA发布了《生成式人工智能应用安全测试标准》和《大语言模型安全测试方法》两项国际标准,后者由蚂蚁牵头主导制订,在采用大模型去治理安全本身方面,华为提出了L4级AI安全智能体,用大模型加上安全的知识图谱来做安全的纵深推理,发现尚未发现的安全攻击;

5月,Open Al发布非常详细的10大AI安全措施,包括模型对儿童的影响及保护措施,包括语料及使用,也提到了选举选票的完整度问题,把模型跟社会问题进行了结合,Open Al还与微软、智谱AI等签署《前沿AI安全承诺》,强调对前沿技术的自我约束,智源人工智能研究院与英国AISI建立沟通;

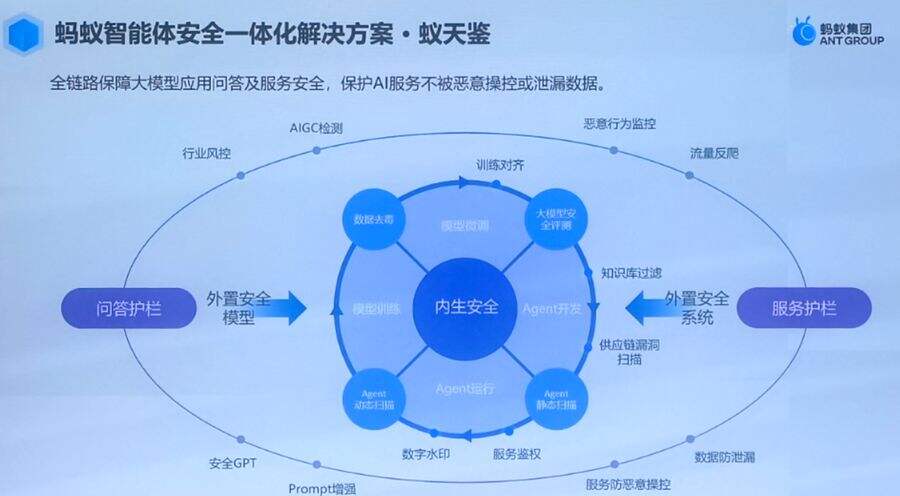

6月,蚂蚁集团发布大模型安全一体化解决方案“蚁天鉴”2.0,Google发布SAIF(Secure Al Framework)安全AI框架;

9月,《AI安全国际对话威尼斯共识》发布,Stuant Russell、姚期智、Yoshua Bengio、张亚勤等专家参与,分析对前置性的监管要求以及模型努力达到的程度,应该采用什么分级模式去进行管理,强调应对模型的不可控、不可知带来的影响;全国网络安全标准化技术委员会发布《人工智能安全治理框架》,智源人工智能研究院推进新版本迭代;

10月,Anthropic更新其制定的《安全责任扩展政策(RSP)》,对模型进行了要求高得多的分级,如把类似小模型不造成重大灾难的人工智能看作风险状态,而是把武器制造等跨过边界的引导性认为是当前大模型的风险,美国今年还在推进两个法案,如定义用到10的26次方规模的模型要有特别管制的机制;

12月,OWASP“大语言模型应用程序十大风险 2025”发布,智源人工智能研究院推出泛化的AI防御大模型和AI监管大模型等。 这些机制都是站在模型开发的生命周期,包括语料管理模型自身安全性的管理,以及输出管理。

值得一提的是,在具体实践方面,蚂蚁推出的“倚天鉴”的安全解决方案,已经用于小模型在在评估AI的鲁棒性、可解释性和公平性方面,而大模型应用时对这套系统进行了全面升级和发布。其核心要素是“蓝军”的测评,有专门的攻方团队对模型全面检测和实践化测评,包括框架、第三方插件、coding等,也针对发现的一些漏洞进行应对:在内生安全方面,主要解决语料安全分布、语料治理问题,对语料中像个人信息等不合规的信息深入管理和安全性对齐;在围栏方面,加强对用户交互中的动态监测,排除一些由于多轮和单轮诱导引发的模型错误。另外,对用户的prompt做一些路由分析,避免要求过于严格而影响模型的泛化性。

蚂蚁集团大模型数据安全总监杨小芳介绍“倚天鉴”安全解决方案及AI安全实践

智源研究院推出了防御大模型和AI监管大模型,核心技术体现在对齐优化上。因为模型本身有一定的弹性,但原来的分布比较坚固,有抗拒微调对齐的特性存在。因此,在对齐训练和预训练时把对齐需要的表征表达到训练的模型中,消除未对齐答案和对齐答案之间的偏差,更有利于原始问题到直接问题的训练,实现优化过程。通过把多模态信息和对齐跟现实世界的具身以及多模态、全模态的类型和人类意图对齐,智源研究院Llama在微调时取得了很好的效果。

未来安全领域应当关注的其他话题

谈到未来安全性方面还应该关注的话题,彭晋着重指出了以下几个方面:

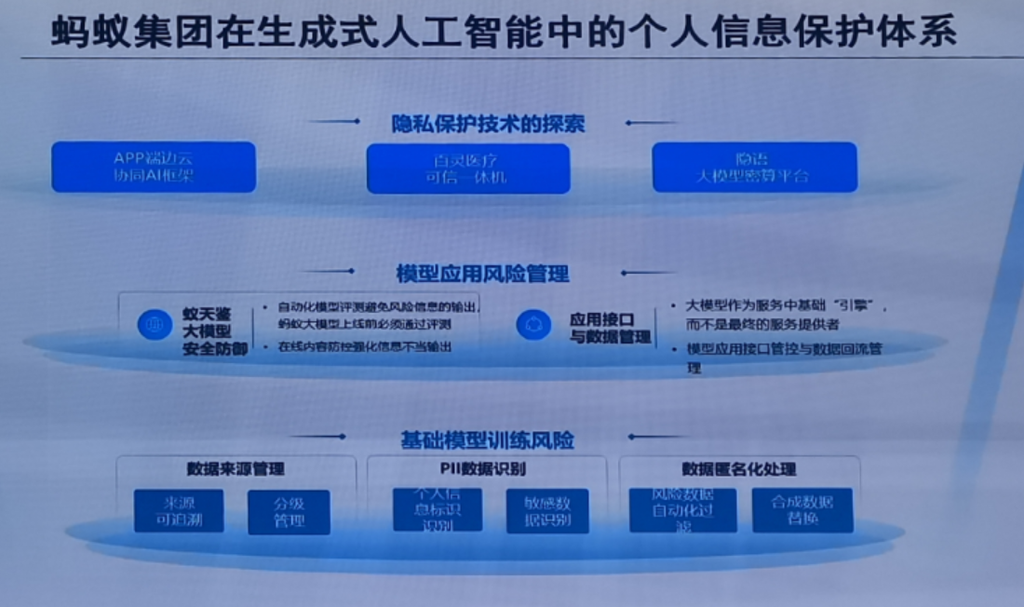

一是数据问题。数据分散在各个孤岛上,在数据枯竭、算力和数据分离的情况下,用什么方式保证数据训练的安全性?隐私计算、联邦计算方式可一定程度确保领域里的数据、孤岛里的数据应用于训练中;

二是数据合规治理的问题。如个人信息保护问题,国家出台很多关于个人信息保护相关的法律和标准,也提到匿名化方式来确保个人数据不被识别,且可以用在训练过程里,但缺乏实际操作指导。

三是很多倡议和法规过于宏观,缺乏实操性。如威尼斯倡议、北京共识等,国家出台的人工智能治理办法等又非常中观。这些举措在微观操作上缺乏确保大模型的安全性能够应对新的攻击和做好安全测评分级等等具体的规范、标准来作为指引。此外,涉及大模型安全的那些核心问题,无论是当下幻觉的产生,还是未来可控性、可解释性的把握,也是未来大模型安全中的重要因素。

“安全”这个词在英文中已经混合,既包括Security也包括safety。从长远的角度,人们更加关注模型是否可信,可控性、专业性、可靠性、安全性等都是大模型将来实现应用和实现人机协同的关键环节,安全只是其中一个部分。

“从这个角度,未来有更宽泛的问题需要在未来进行研究。”彭晋最后说。

- About

- Latest Posts

- 蚂蚁集团:构筑完善的安全治理体系,推进模型能力快速提升 – 2025年1月12日

- 好大夫正式牵手蚂蚁集团,共同推进“AI+医疗”创新 – 2025年1月11日

- 区块链重新定义绿电交易 巴西首笔户用光伏国际绿证完成交易 – 2025年1月10日

- 连开三大跨境商家中心,菜鸟为中小商家量身定制国际快递服务 2025-01-13

- 微秒必珍,炫彩共时 ZENITH真力时于广州开启“WATCH CLINIC”制表课堂 2025-01-13

- 增程豪华旗舰之争 星纪元ET与问界M7、理想L7谁更胜一筹? 2025-01-13

- 蚂蚁集团:构筑完善的安全治理体系,推进模型能力快速提升 2025-01-12

- 7万吨碳汇出让获利224万元 湖南成交首笔水土保持碳汇交易 经济要闻 华声经济 2025-01-12

- CES 2025:车企角逐智能化,融合与赋能成为关键词 2025-01-12

- Lumileds 推出全新 LUXEON 5050 HE Plus LED,为户外和工业照明提供 199 流明/瓦 2025-01-12

- 宝玑臻选时计 贺岁乙巳蛇年 2025-01-12